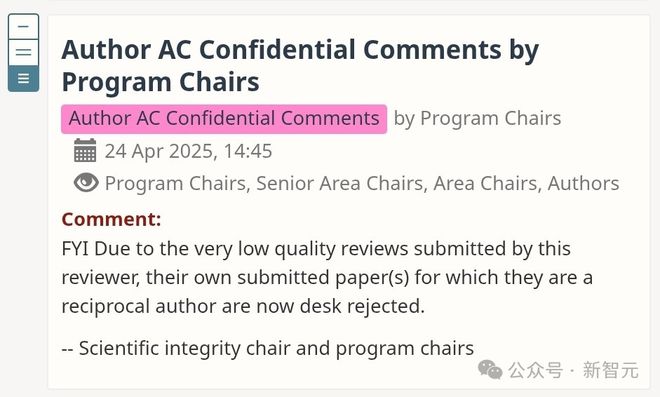

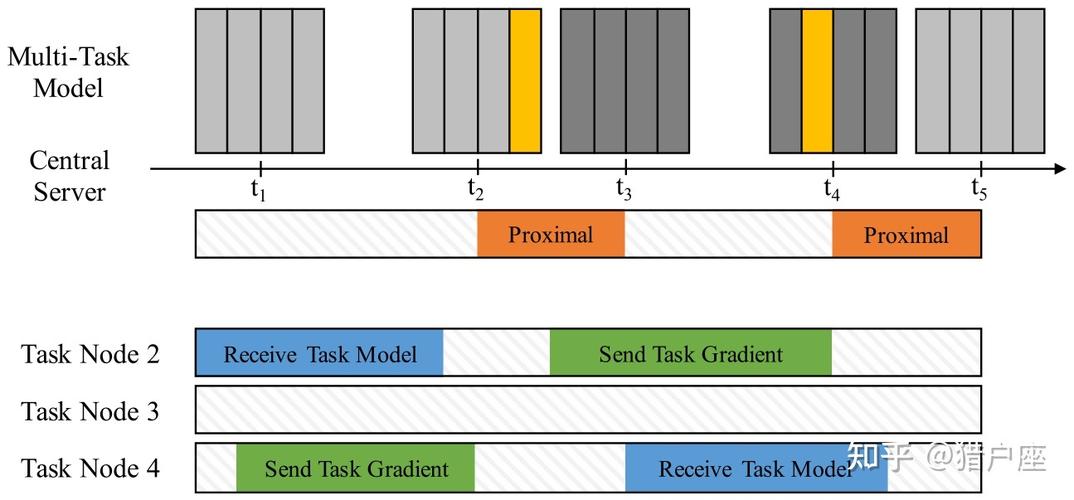

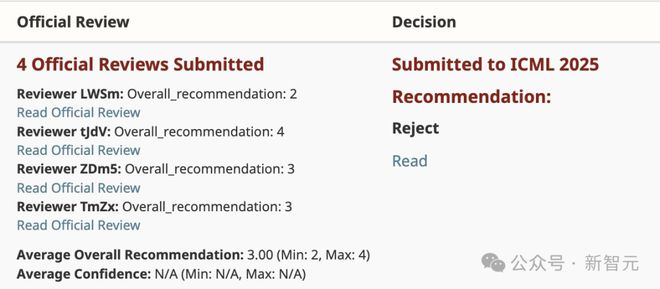

本文是FedExProx,它是一种基于分布式外推的近端方法,能提供更紧密的收敛性结果。先前分析显示该方法在二次问题上的迭代复杂度不比梯度下降法好,不过本研究表明实际能获得更快的收敛保证。审稿人对技术结果的清晰阐述给予高度评价,基于整体理论贡献,对实证评估也基本满意。这些研究结果,为分布式优化,提供了新的见解,涉及可达到的收敛速率,存在微妙差异。

有网友为审稿人找理由辩解,也许是手抖不小心点了「拒稿」,还有人猜测,这显然是AI生成的审稿建议。

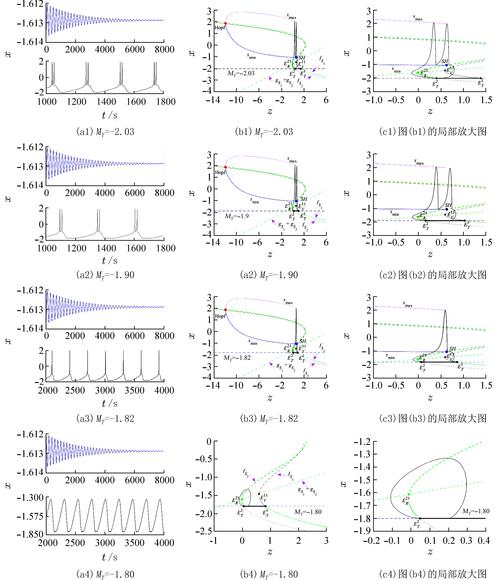

左右滑动查看

另一位来自约克大学的博士生深有同感地说 ,「我对此并不觉得意外 ,因为我们的论文也碰到了这样的情况」 。

更惨的是,他的论文评审更加敷衍,审稿人都没有写完就提交了。

而且,AC仍旧以这篇有缺陷的评审为由,拒收论文。

MBZUAI助理教授Zhiqiang Shen表示,两篇论文都被拒绝了,他对AC评审结果极为失望,因为评审结果存在大量事实错误 。

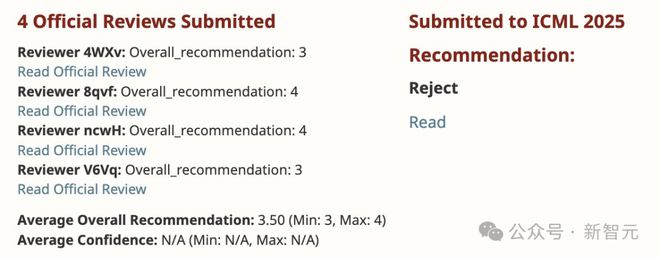

论文4433实际得到了两个4分,然而元评审却错误地记录成了「三个3分和一个4分」。

论文4332的审稿人在rebuttal之后更新了评分,然而元评审却错误地引用了旧评价。

这种前后不一致的表述让人感到困惑,这到底是因为疏忽,还是没能正确整合审稿人的更新反馈呢?

无论原因如何,这都严重损害了评审的公正性。

南洋理工大学助理教授Mengmi Zhang表示,有另一篇论文,它获得了所有ICML审稿人的一致通过,然而却遭到了区域主席的拒稿 。

她认为,「如果这就是同行评审,那么有些地方出问题了」。

一位来自UT的审稿人表示,他自己在ICML 2025审稿时过于宽容,现在的学术会议完全是零和博弈。

从现在开始,只要是没有运用30万亿token进行预训练671B MoE模型的论文,哪怕有着再强大的理论保障,都会被坚决拒绝录用。

以后,难道30万亿token,要成训练MoE硬标准了么?

目前,那些拿到录用结果的网友们,纷纷晒出了自己的成绩单。

网友晒成绩单

杜克大学陈怡然教授公布了ICML的成果,团队有5篇论文被顶级会议录用,另外有一篇与宾州州立大学合作的论文被选为Spotlight Poster 。

北大计算机系张铭教授所带领的团队,一共有4篇论文获得奖项,这一数量和去年被录用的论文数量是一样的。

UC伯克利博士后研究员Xuandong Zhao,心情激动,晒出了三篇论文,这三篇论文被ICML接收了。

左右滑动查看

新加坡国立大学的Kun Zhou(周坤)有一篇关于神经编码器Muffin的文章,该文章被正式录用,这种神经编码器Muffin能够在多种音频类型中,实现高保真音频压缩。

香港大学团队,自主研发了GUI交互的统一纯视觉智能体模型,该模型AGUVIS上榜了。

UC伯克利的博士生Kayo Yin写了一篇关于上下文学习注意力头的论文,这篇论文被顶会录用了。

佐治亚理工学院助理教授Humphrey Shi的博士生有一篇论文被拒了,这篇论文是他花费近一年时间做出的成果 。

他进行勉励,说道,“被拒稿这种情况是很常见的。要持续学习,持续前进,因为真正的评判者在你自己心中” 。

参考资料:

%202025&src=typed_query